El ecosistema analítico de MercadoLibre

Cuando pensamos en las empresas tecnológicas podríamos algunos pensar que trabajan con uno o algunos softwares de pago, como por ejemplo el banco que paga por tener MATLAB, el organismo internacional que trabaja con STATA o las empresas que usan SAP, por mencionar los casos más comunes. Pues hoy les traigo una radiografía de cómo se encuentra formado el ecosistema analítico de MercadoLibre.

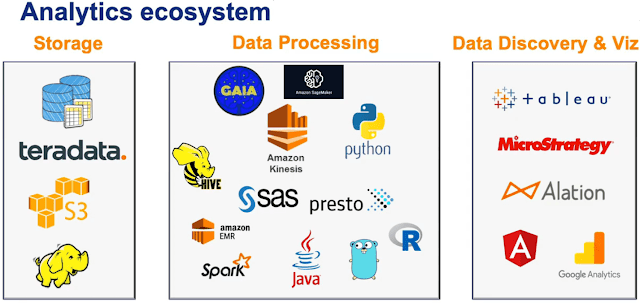

Para aquellos que no lo sepan, MercadoLibre alberga la mayor plataforma de comercio en línea de América Latina con 3,3 millones de vendedores y 267 millones de usuarios. La siguiente Figura muestra el ecosistema analítico de la empresa:

Sin embargo, este ecosistema no ha sido siempre así, este proceso de transformación hacia la democratización de los datos inició hace 5 años. En ese momento, MercadoLibre tenía un modelo de Business Intelligence (BI) tradicional en el que los usuarios hacían una solicitud al equipo de BI y luego esperaban para obtener una respuesta, ya sea en horas, días o incluso semanas. Este modelo simplemente no podía escalar. Los usuarios de negocios necesitaban mayor agilidad para manejar el negocio.

Actualmente, MercadoLibre atribuye el crecimiento de su éxito en el autoservicio a unos pocos pilares clave de su enfoque. En primer lugar, formularon programas de capacitación para educar adecuadamente a los usuarios sobre los recursos y procesos de la empresa, que han sido fundamentales para la sostenibilidad de la práctica analítica. En segundo lugar, un programa de usuarios clave trajo a gente de fuera de la división de BI para trabajar junto a los analistas como consultores. Finalmente, un modelo descentralizado colocó células de BI en toda la organización para ayudar a los departamentos con sus análisis, incluyendo la contratación de las personas adecuadas para el trabajo. Y el hilo conductor de todo esto es el enfoque estratégico de la empresa para la gestión.

Los tres pilares del ecosistema analítico de MercadoLibre son: almacenaje, procesamiento de los datos y el análisis visual de los datos. Para el almacenaje usan Teradata, Amazon Simple Storage Service (Amazon S3) y Apache Hadoop.

Para el procesamiento de los datos, es una integración muy variada y con una fuerte presencia de los servicios provistos por Amazon como Amazon EMR que sirve para una ejecución y escalado sencillos de Apache Spark, Hadoop, Presto, Hive y otros marcos de big data. Así como, Amazon Kinesis (para la recopilación, procesamiento y análisis de transmisiones de datos y videos en tiempo real) y Amazon SageMaker para el aprendizaje automático. Además de la combinación de los lenguajes de programación como Java, Python y R, todo esto complementados con la plataforma de análisis de datos provista por SAS.

Comentarios